栏目分类

发布日期:2024-09-19 03:00 点击次数:75

裁剪:桃子 乔杨波多野结衣贴吧

【新智元导读】OpenAI博士级别的智能,果然终光显!一位UCI物理学博士实测o1,发现我方用时1年完成的博士论文代码,竟被AI在1个小时之内终光显。

o1模子依然强到,简略直出博士论文代码了!

来自加州大学欧文分校(UCI)的物理学博士Kyle Kabasares,实测o1 preview+mini后发现:

我方肝了大要1年的博士代码,o1竟在1小时内完成了。

他称,在大要6次请示后,o1便创建了一个运行版块的Python代码,样貌出研究论文「景观」部分的内容。

天然AI生成的代码框架,模拟了Kabasares履行代码功能,但它使用的是「合成数据」,并非确凿的天文数据。

不外,o1简略在这样短时候输出复杂代码,足以震荡。

视频右下角中,Kabasares连连喊出「oh my god」,各式难以描摹的动作情绪,被畏惧到怀疑东谈主生。

YouTube视频一出,便在全网掀翻热议,网友们纷纭泄漏太纵脱了。

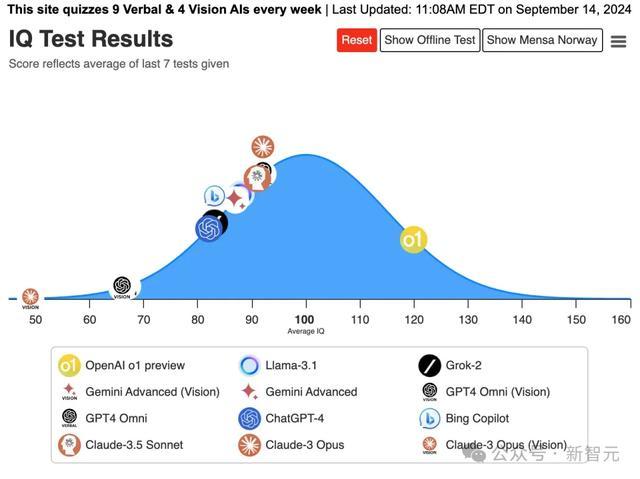

好巧不巧的是,o1在最新门萨才能测试中,IQ水平竟越过了120分。

35个才能题,答对了25谈,把其他模子甩出好几条街。

然则,这只是是o1模子的preview版块。

OpenAI研究东谈主员David Dohan曾发文示意,一个月后,o1模子还将有全新的升级版块。

届时,还不知o1性能,将有何等逆天?!

物理学博士论文,AI 1小时直出200行代码

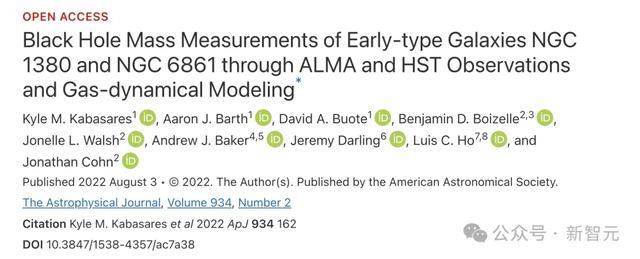

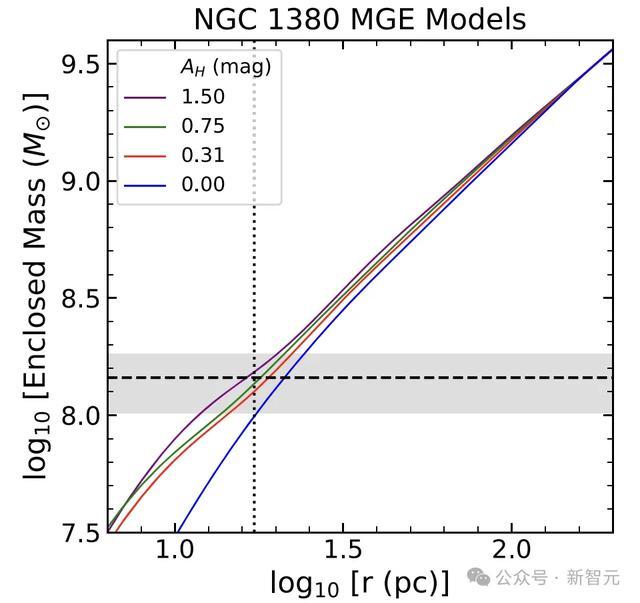

2022年,物理学博士Kabasares以第一作家身份,在「天文物理期刊」发表了这篇对于,通过对天文数据建模来测量黑洞质料的论文。

天然,这篇研究不单是是写代码,但终了这段代码,是Kabasares博士第一年的关键冲突。

不错说,在他博士研究的阶段的第一年(2018年7月-2019年4月),破耗了大都时候,才让这段代码第一版正确运行起来。

这亦然,为什么o1能在1小时内,给出一个可运行的Python代码,让Kabasares印象深远。

视频中,看到o1输出的代码后,Kabasares缓了好大一阵儿,才运转接下来的解释。

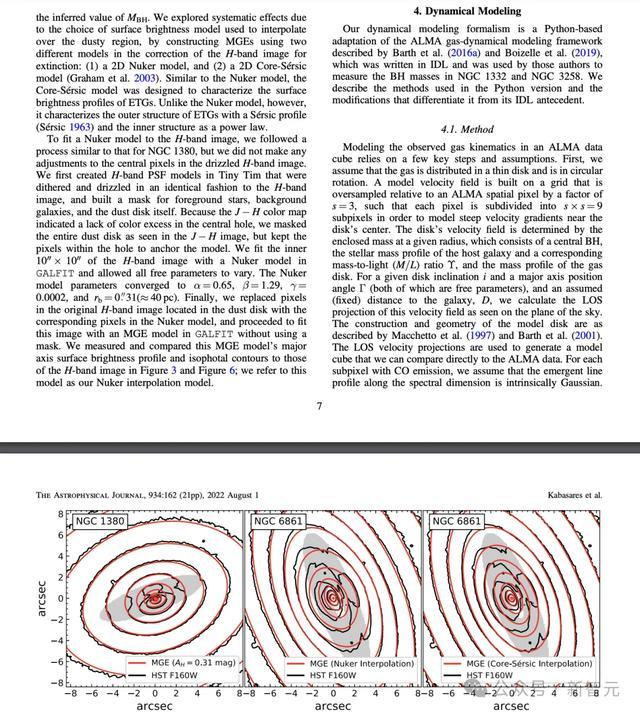

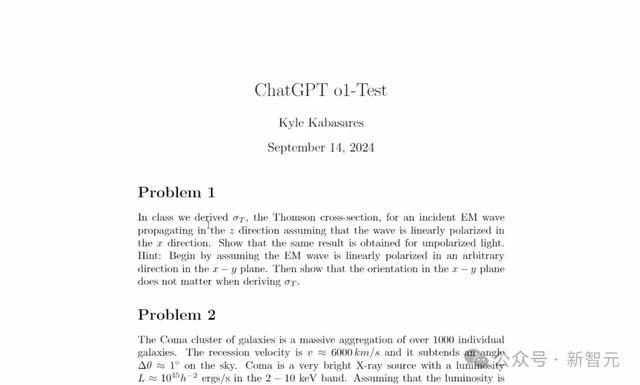

他向ChatGPT o1提供了论文中,「景观」部分的内容(即第4节),并请示阅读我的论文,证据所给信息,写出一段Python运行代码。

他屡次强调,我方莫得向o1展示我方代码。

在于ChatGPT对话页面中,Kabasares向世界展示,并细数了下o1是在6次请示下,完成200行代码。

不外,他也提倡教诲,履行上还需要咱们我方去作念一些极端的责任。就像论文中这个弧线图,还得需要在另一个软件,比如星河图像软件中完成。

当网友参谋到,有莫得可能o1就着你我方的代码,完成的熟悉?

Kabasares以为,o1输出的200行代码,与我方1100行代码有着很大的不同,这是论文代码「最简版块」。

深夜测试,o1挑战大学、博士物理题

为此,Kabasares又发了第二弹视频,向统统东谈主解释o1可能果然莫得接纳过数据熟悉。

值得一提的是,他从办公室拿到的好意思妙文献,是由素养亲身谋略的天体物理知识题。

这些题目,都是Kabasares在博士时间完成的,并莫得发布到互联网上。

他专门为o1出了一个测试集,一共有4谈题目。

而在莫得熟统共据的情况下,o1输出的收尾无须说。以至,有的题它仅在16秒内,完成了解答。

还铭记,OpenAI CTO Mira Murati在接纳采访中泄漏,GPT-4之后的新模子将达到博士级别的智能。

o1当今的解析,依然是关键的一滑。

代码编程赛,行家级别

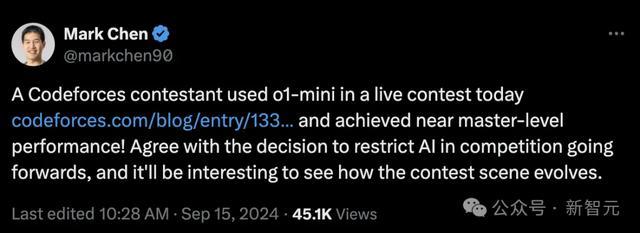

动作OpenAI的研究主宰兼现任的IOI好意思国队西宾,Mark Chen共享了o1模子在Codeforces比赛上的最新进展。

在Codeforces昨天的实时比赛中,一位名为AryanDLuffy的选手使用了o1-mini模子进入比赛,收尾相当惊艳。

用Mark Chen的话来说,达到了「接近行家级别的解析」。

AryanDLuffy发帖泄漏,我方莫得进行任何请示工程,只是是给出问题陈述,并告诉模子用C++解题。

7谈题目中,o1-mini仅在B2、D和E2碰到了贫乏,其中D和E2是不少排行前50的选手也没能得分的,亦然提交东谈主数最少的两谈题目。

最终,o1-mini匡助AryanDLuffy取得了3922分的总收货,在越过16万参赛者中排行277,也就是排行在前0.17%。

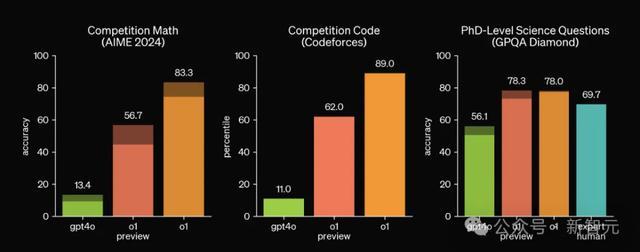

这远远越过了OpenAI我方作念的基准测试收尾。o1模子在他们的模拟Codeforces比赛中还只是越过了89%的东谈主类选手。

277的排行比较AryanDLuffy本东谈主之前的记载提高了158位,达到了4年来最大的越过幅度。

对此,Mark Chen和好多网友的目的是,IMO和Codeforces的竞赛题也许不错动作新式的LLM基准测试。然则,Codeforces的主理方驰念的是另一件事。

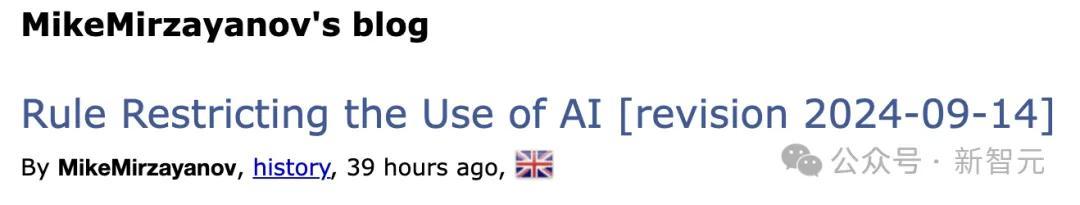

竞赛首创东谈主Mike Mirzayanov为此成心制定了一条新规:遏抑使用GPT、Gemini、Gemma、Llama和Claude等各式模子来料理Codeforces竞赛中的编程问题。

但是这条新规并不是条件参赛者十足放置AI,他们依旧不错让模子赞助翻译问题陈述,或者向Copilot寻求语法匡助和次要的编码建议。

简而言之,竞赛问题的中枢逻辑、算法,以及bug的会诊调试,都必须由东谈主类选手独处完成,CF也会进行舞弊检测。在非竞争性问题中,AI器用的使用则十足不受阻抑。

但也有用户指出,舞弊检测实质上很难实践,参赛者简便修改一下AI生成的代码就不错「逃过高眼」。竞争性编程竞赛的翌日,很猛进度上决定于选手们我方能否守信。

CF也泄漏,会合手续关爱AI时刻的进展,并证据需要实时调整礼貌。

在博文中,Mirzayanov将神经收集的进展称为「时刻遗迹」,因为不久前这些模子还很难完成竞赛中最简便的任务,但当今却达到了马虎残忍的高度。

他泄漏,「咱们有事理笃信,这种越过会合手续下去,AI可能会在编程竞赛领域不绝取得新的冲突。」

陶哲轩实测后续

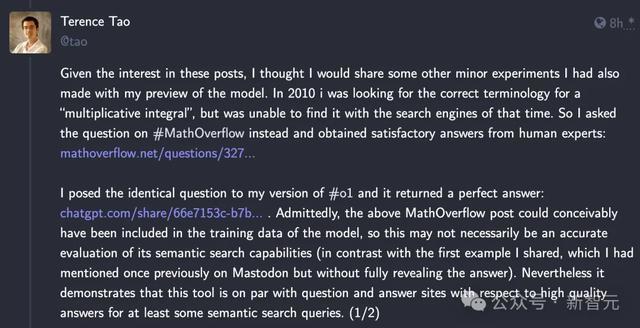

除了Codeforces,陶哲轩大神也泄漏,由于世界对他之前测试的酷爱酷爱,因此不绝放出了一些其他的o1 preview实验收尾。

第一个实验,是找术语。

2010年,我正在寻找「乘法积分」的正确术语,但其时莫得用搜索引擎找到。于是我转而在MathOverflow上提倡了问题,并从东谈主类各人那边得到了舒心的谜底:

14年后的今天,陶哲轩再次向o1模子提倡了疏通的问题,问题表述都和MathOverflow上的帖子简直一模一样。

比较东谈主类各人,o1给出的谜底愈加全面而况圆善。不仅包含了5个可能的术语,还附上了相应的数学泄漏、应用领域和参考文献。

陶哲轩泄漏,天然这篇MathOverflow上的帖子可能依然包含在o1的熟统共据中了,但依旧能展现模子在语义搜索方面的宏大功能,而况征集、追思出的谜底的质料不错与MathOverflow这类专科的问答网站相当。

另一个实验则更具创造性,与陶哲轩本东谈主的研究径直计划。

动作另一个小实验,我给了o1我最近的博客著述的前半部分,其中追思了之前我我方简略料理的鄂尔多斯问题的进展。

要将之前的部分进展调养为全面的料理决策,仍缺失一些要素,我条件o1模子找到这些调养要素,但收尾有点令东谈主失望。

履行上,模子提倡的计谋与博客中重述的最新研究是疏通的,并针对该计谋莫得提供任何创造性的转换。

总的来说,我觉适天然LLM器用有一定的才能,不错立时生成创造性计谋,但这方面的LLM器用仍然相当薄弱。

多篇论文讲述o1运作机制,DeepMind上大分

o1模子发布不到一周,咱们就依然见证了这样多惊东谈主的用例,AI时刻界对o1背后的机制和旨趣亦然众说纷纭。

前谷歌搜索工程师、Menlo Ventures风投家Deedy Das曾斗胆猜想,其主要旨趣来自DeepMind一篇本年8月发表的论文。

论文地址:https://arxiv.org/abs/2408.03314

论文提倡,让LLM进行更多的「测试时谋略」(test-time computation),对于构建能在绽开语境下操作、能终了自我擢升的agent,是关键的一步

而这篇论文就重心研究了推广「推理期谋略」(inference-time computation)这个问题。

研究团队分析了推广测试时谋略的两种主要机制:(1)针对密集的、基于历程的考证器奖励模子进行搜索;(2)证据测试时得到的请示词,自符合更新模子对反应的散布。

收尾浮现,在这两种情况下,对测试时谋略的不同推广景观的有用性,很猛进度上取决于请示词的难度。

基于此,研究团队提倡了一种「谋略最优」推广计谋——通过为每个请示词自符合地分派测试时谋略,使测试时谋略的推广的后果提高4倍以上。

另外,在FLOPs一致的评估中,对于那些较小的基础模子已取得一定进度非当年见效用的问题,测试时谋略不错使其超越领域大14倍的模子。

此外,HuggingFace时刻主宰Philipp Schmid也开列了一份论文清单,包含了o1模子可能的责任旨趣,主要对于通过熟悉/RLHF而非请示工程,擢升LLM在复杂任务上的推感性能。

这5篇论文都发表于本年或客岁,不错说是代表了细分所在的前沿进展。

第一篇是斯坦福和Notbad在本年3月提倡的Quiet-STaR(Self-Taught Reasoner)。

论文的目的开始于这样一个直观:在写稿和讲话时,东谈主们随契机停驻来想考,但想考和推理的内容不会显式地抒发出来,而是隐含在书面文本中。

因此,假想情况下,语言模子不错学习推断文本中未发达的基本心趣。

Quiet-STaR是对2022年发表的STaR的引申,让模子为每个token生成基本心趣来解释翌日的文本,从而擢升估量才能。

第二篇相似是斯坦福学者和MultiOn在本年8月合营发表的AgentQ框架。

他们将蒙特卡罗树搜索(MCTS)与自我品评机制相妥洽,并使用径直偏好优化(DPO)算法的off-policy变体对agent的交互进行迭代微调。

这种景观允许LLM agent同期从见效和不行功的轨迹中进行有用学习,从而提高在复杂的多模范推理任务中的泛化才能。

第三篇则针对数学推理,以期擢升模子的问题阐述才能和「反想」才能。

具体来说,论文提倡了一种新颖的「反想增强」景观,将问题的反想镶嵌到每个熟悉实例,熟悉模子探讨其他可能的视角,并进行概述和类比,通过反想性推理促进更全面的阐述。

V-STaR这篇著述相似是对STaR框架的引申,发表于本年2月。

论文提倡,原有的STaR景观在迭代历程中丢弃了大都不正确的料理决策,可能忽略了其中有价值的信息。

V-STaR恰是要弥补这个颓势,它同期行使了自我改良历程中生成的正确和诞妄的料理决策,用DPO熟悉出一个考证模子,以判断生成的料理决策的正确性。该考证器在推理时使用,从候选料理决策中进行聘任。

实验发现,运行V-STaR进行屡次迭代,不错逐步熟悉出性能更好的推理模子和考证模子。

Let's Verify Step by Step这篇论文,就是由AI大牛Ilya带队完成。

论文中,主要探讨了大模子在复杂推理中,何如优化熟悉计谋的问题,尤其是,何如行使CoT进行想考。

他们提倡了历程监督景观(process supervision),由此熟悉的一种全新模子,在料理数知识题上取得了冲突。

这一计谋的宏大之处在于,比起收尾监督,在推理历程中逐步奖励,进而让模子性能显赫擢升。

除了推特帖中一运转触及的5篇,Schimid还在HuggingFace上单开了一个网页,合手续搜罗磋论说文,目下依然涵盖了7篇。

o1能否终了自我擢升

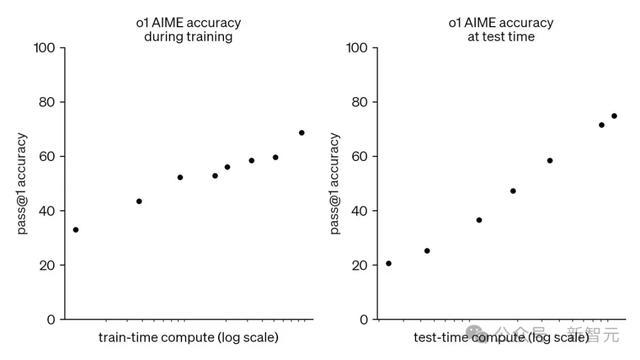

Jim Fan在一篇分析帖中指出,o1模子给咱们带来的关键成见是这两条弧线的皆头并进——熟悉时的scaling law和推理时的scaling law,此后者才是信得过降服收益递减的关键身分。

此外,他还cue到了两篇论文,简略料理咱们对于「o1自我擢升才能」的疑问。一篇是Meta和NYU在本年1月提倡的「自我奖励的语言模子」。

这篇著述基于一个绝顶简便的目的:对归拢个LLM进行请示,指点它生成反应并自我奖励,进行迭代自举。

论文称,奖励建模才能不再属于一个固定、独处的模子,而是不错奴婢主模子的措施擢升。但真义的是,最多3次迭代之后,依旧会出现模子充足。

对此,Jim Fan的目的是,动作评述者(critic)的奖励模子,擢升速率小于动作活动者(actor)的生成模子,因此尽管二者都在擢升,最多3轮迭代后,后者就会追向前者,达到充足。

另一篇著述是DeepMind客岁8月就发表的ReST(Reinforced Self-Training),其实验收尾也很访佛:在达到收益递减前,最多进行3轮迭代。

这两篇论文似乎解释了,评述家和活动者之间不存在可合手续的才能差距,除非引入外部驱动信号,比如记号定理考证、单位测试套件或编译器反馈。

但这些都是特定领域的高度专科化的内容,要想终了咱们假想中的LLM的通用自我擢升波多野结衣贴吧,还需要发掘和探索更多的研究目的。

上一篇:反差 推特 港股异动 | 嘀嗒出行(02559)盘中涨超23% 上半年利润增超50% 公司已与多个头部互联网平台结束合营